| 九游集团品牌机器人 |

| CHUANGZE ROBOT |

机器人遥操作(Teleoperation),也可以称为Telerobotics,是指在相关机器人控制中把人类操作包含在控制回路中,任何的上层规划和认知决定都是由人类用户下达,而机器人本体只是负责相应的实体应用。当机器人处理复杂的感知和大量任务时,在快速做出决策和处理极端情况时,遥距操作远远优于智能编程。

目前遥操作已广泛应用在医疗领域、极端环境探索如太空与深海场景、防恐防爆应用场景,及基于工业机械臂的自动化生产中。机器人遥操作可以大致分为基于设备的接触式遥操作和基于无标记的视觉遥操作两大类。2009年以前的工作可以参考[1],下面就近几年的遥操作发展进行介绍。本文主要关注服务机器人和工业机器人,不涉及医疗机器人,如对医疗机器人感兴趣可参考[2]。

一、接触式遥操作

接触式遥操作通常通过遥操作者穿戴或操作不同类型的设备来实现。这些设备有操作杆、类如Apriltag的标记物,惯性测量单元IMU,肌电图(EMG)信号传感器,虚拟现实VR/增强现实AR设备以及前景广阔的触觉设备等。

1. 基于IMU和EMG的遥操作

基于IMU和EMG的遥操作方法成本低且高效易操作。2017年,清华大学孙富春教授课题组设计了一个集成18个IMU的穿戴手套,并开发了基于扩展卡尔曼滤波器的多模态融合算法用于推算人手臂和手的方向与位置[3]。这种新颖的遥控方案稳定地应用于由SCHUNK手臂和Barrett三指手构成的11DOF机械臂-手系统,以及由UR5和Barrett三指手构成的10DOF机械臂-手系统,其中操作员的手指用于机械手遥控,而手掌的手臂用于机械臂遥控。

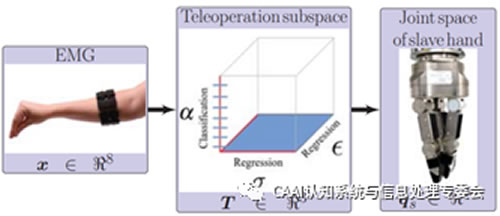

2019年,哥伦比亚团队提出了一种由EMG驱动的非拟人化机器人手遥操作方法,这种方法将人前臂的EMG信号连续映射与远程操作相关的三个子空间中,然后再从这个子空间映射到机器人手的关节空间[4]。这个方法有效且直观,使新手操作者更快熟悉操作方案,可以鲁棒地完成远程操作拾取和放置任务。

2. 基于VR/AR的遥操作

基于虚拟现实的机器人遥操作是克服时延的有效方法,具有透明性强、稳定性高的优点,成为当前机器人遥操作的主要方式。汉堡大学团队使用微软hololens穿戴式眼镜,基于混合现实(MR)技术为人机交互(HRI)场景开辟了遥操作的新前景[5]。在MR人机协作系统中,操作员不仅可以看到机器人的真实工作场景,并且其他虚拟信息可以叠加在真实场景的视图上,实现直观自然地控制用于抓取和放置任务的机器人。特别是在机器人执行动作之前,操作员可预览机器人的潜在规划动作,可以减少损坏系统或伤害操作人员的风险。此外,作者也在多机器人系统的交付服务任务中验证了这个系统。这些研究为未来VR、AR及MR装备的设计及虚拟现实在机器人方向上的应用提供了重要的启示。

3. 融合触觉反馈的遥操作

触觉反馈对于接触丰富的外部操作任务至关重要,触觉设备已在外科手术机器人中得到广泛研究,并用于在虚拟现实应用程序中收集训练数据,如HaptX development kit。一些商业产品CyberGlove、HaptX以物理阻力和空间接触的形式提供了触觉反馈,但是这种好处伴随着成本的增加。HaptX与Converge Robotics Group(由国际公司组成的财团)共同开发了TactileTelerobot远程机器人,以推动触觉和机器人技术的发展 [6]。TactileTelerobot是世界上第一个能够将逼真的触摸反馈传输给位于世界各地的操作员的机器人系统,该系统集成了三个主要产品,每个主要产品都在其类别中处于领先地位:Shadow Robot Hands,SynTouch BioTac传感器和HaptX Gloves。Tactile Telerobot通过真实无延迟的触觉反馈实现了多种机械手灵巧操作,如倒水、拧瓶盖、转魔方、写字、开纸盒、帮人带耳机,甚至人体按摩等。

当然这种昂贵的触觉设备并不是每个组都可以拥有,因此还有一些双向遥操作控制设备在[7]中,通过定义一个虚拟的操作对象来捕获在master侧人手的运动及slace侧相关的力反馈。

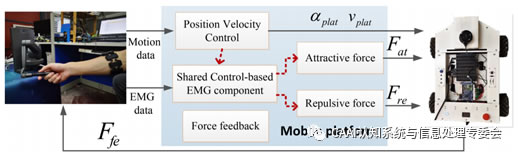

除了使用遥操作技术对机械臂或者机器手的控制,2020年西英格兰大学的杨辰光团队提出了一种用于全向移动机器人的EMG与触觉设备混合控制方法[8]。这种混合共享控制方法基于肌电图和人工势场,用以根据排斥力和吸引力避开障碍物,并基于移动平台的力反馈增强人类对远程环境的感知。这种共享控制方法使遥操作者远程控制移动机器人的运动并同步实现避障。与传统的共享控制方法相比,该提议的方法提供了基于肌肉激活的力反馈,并驱动操作者以可预测的方式更新其控制意图。最终通过各种避障实验表明这种遥控方法对移动机器人控制的有效性。

二、基于无标记的视觉遥操作

与基于接触式或可穿戴设备的远程操作不同,基于无标记的视觉远程操作具有还原人体四肢自然运动且侵入性较小的优点。特别是针对高自由度的机器手的遥操作,使用穿戴手套的方法必须根据操作者进行定制手套大小,并且手套容易影响的关节自然运动,而基于IMU或EMG的方法通用性和灵活性较低。因此无标记的视觉方法尤其适用于灵巧手的远程操作,这样有利于捕获手指的所有运动。

基于分析视觉的远程操作分为两类:基于模型的(model-)方法和基于外观的(appearance-)方法。基于模型的方法提供连续的解决方案,但计算量大,通常取决于多相机系统的可用性。相反,基于外观的方法可以识别离散数量的手势,这些手势通常对应于该方法的训练集,而无需高昂的计算成本和硬件复杂性。最近,越来越多的研究人员致力于基于数据驱动的基于视觉的遥操作方法,这些方法首先使用深度卷积神经网络(CNN)获得3D手势或识别手势类别,然后再映射人的相应位置到机器人上。比如,希腊克里特大学Antonis Argyros团队提供了三种基于深度相机的人体位姿估计和跟踪方法,然后通过逆运动学过程将人体运动映射到NAO人形机器人,从而实现对人性机器人的操作[9]。然而,这类解决方案不仅依赖于手势估计或分类的准确性,而且增加后处理的时间成本。

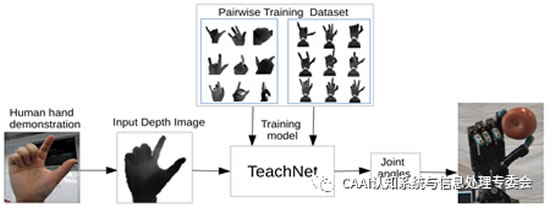

2019年,德国汉堡大学张建伟课题组和清华大学孙富春课题组共同提出TeachNet,一个直接从人类手指深度图获取机器人关节角度的深度学习网络[10]。这种方法只需使用一个深度相机,并实现端到端地控制机器人,是非常直观和用户友好的遥操作方法。TeachNet结合了一个一致性损失函数consistency loss,可以处理人手和机器手的外观和内在结构差异。这个网络的训练依赖于一个合成的400K人手-机器手数据集,其中人手数据来自于人手位姿深度图像数据集BigHand2.0,然后在Gazebo中采集对应每个人手的的机器手深度图像。最后,作者在5个不同操作者的抓取实验中证明了TeachNet的稳定性和高效率。但是这种方法仅限于机器手的控制,无法移动机械手使之在可达工作空间内进行抓取。

进一步,2019年,美国NVIDIA研究所和卡梅隆大学共同开发了一种低成本的基于视觉的远程操作系统DexPilot,该系统允许仅观察裸手就能完全控制整个23 DOF的机械臂-手系统[11]。DexPilot使操作员能够执行各种复杂的操作任务如拧瓶盖、转方块、从钱夹取纸币等,而不仅仅是简单的抓取和放置操作。作者首先使用一个彩色的织物手套采集了一个人手姿势先验数据集,然后使用点云作为输入,结合PointNet++获得人手位姿和关节先验,然后使用DART和动力学重定向将人手关节角映射到allegro手的关节上。最终通过两个演示者完成各种任务的速度和可靠性指标,验证了即使没有触觉反馈该系统仍具有高可靠性和高度灵敏性。

然而基于视觉的遥操作方法明显不能适应于黑暗或者物体被遮挡的情况,因此将视觉与触觉/力反馈融合,将更好地实现鲁棒的遥操作算法。比如,增加机器人抓取时的滑动检测和力估计,或者操作者非示教部位如胳膊或左手用于感受触觉反馈,从而减轻用户的控制负担并避免机器人的意外碰撞。另一方面,当人手被遮挡或者抓握其他物体时,如何解决人手角估计是3D人手姿态估计需要解决的一个方向。再者,基于视觉的遥操作使操作者总是限定于固定的相机系统区域,不能实现移动式遥操作。如何将人手跟踪和人手关节角估计共同应用到机器人的遥操作中也是非常有趣。

|

| 机器人公司 机器人应用 智能医疗 物联网 机器人排名 机器人企业 教育机器人 机器人开发 独角兽 消毒机器人品牌 消毒机器人 |